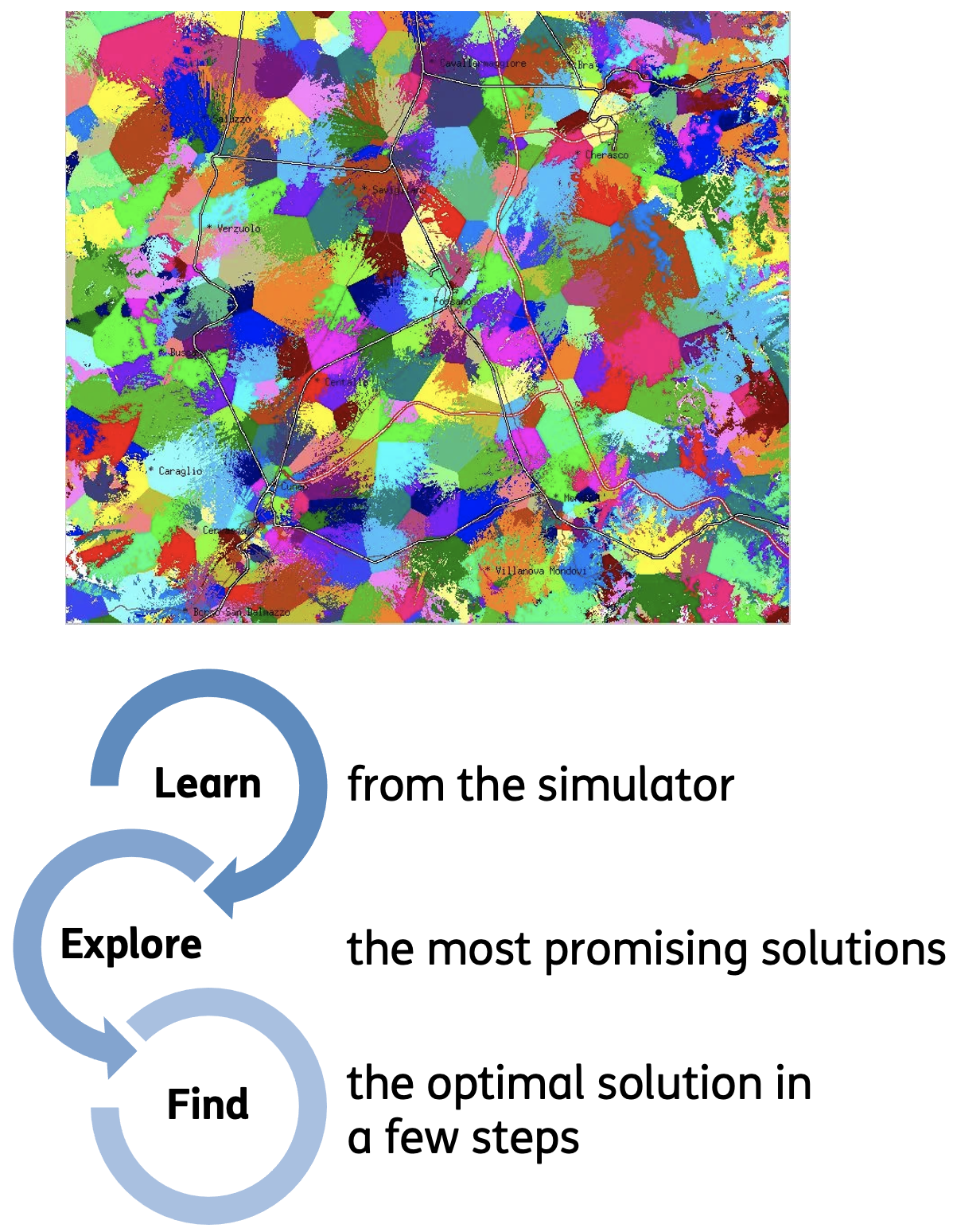

L’algoritmo ERIS (Enhanced Reinforcement learning for Innovating Self organizing networks) nasce dalla collaborazione tra i gruppi di Ingegneria Network Management System & SON e di Data Network Learning in ambito Strategy con lo scopo di sviluppare un sistema automatico e basato su metodologie di Machine Learning (ML) per l’ottimizzazione della copertura e della capacità di un sistema LTE al variare del tilt elettrico delle antenne, nell’ambito degli algoritmi SON di CCO. L’obiettivo consiste nel determinare la combinazione di tilt elettrici ottimale, per un dato insieme di celle LTE, tale da eliminare o ridurre problemi di celle sovraccariche (dette “over target” in quanto caratterizzate da traffico superiore ai livelli target). Un tale problema, in generale, presenta uno spazio delle configurazioni possibili che cresce esponenzialmente al crescere del numero di celle e del numero di tilt elettrici per cella. Infatti, nel caso in cui si consideri uno scenario di sole 14 celle con 5 valori di tilt elettrico per cella il numero di configurazione possibili è 514, pari a circa 6 miliardi di combinazioni, mentre se il numero di celle salisse a 18 allora il numero delle configurazioni diventerebbe superiore a 3800 miliardi. Un approccio che preveda di valutare tutte tali configurazioni per poi scegliere la migliore è chiaramente inattuabile in quanto ogni singola simulazione necessita di molti calcoli e richiede alcuni minuti. Il problema è stato affrontato applicando e sviluppando un algoritmo di Reinforcement Learning (RL) denominato MonteCarlo Tree Search (MCTS) che sceglie la prossima configurazione da valutare usando il concetto di Upper Confidence Bound che soddisfa l’esigenza di esplorare nuove configurazioni nell’intorno delle configurazioni finora risultate migliori. Inoltre, per aumentare ulteriormente l’efficienza dell’esplorazione, il MCTS è stato accoppiato ad un algoritmo di ML per predire il risultato della simulazione prima ancora che questa venga eseguita. Questo permette di eliminare velocemente tutte le configurazioni la cui predizione di valore è bassa, lasciando il calcolo della simulazione alle sole configurazioni più promettenti, velocizzando ulteriormente la ricerca della configurazione migliore. Il SW implementato è in grado, tramite l’uso di TIMplan usato come simulatore di sistema, di navigare in modo efficiente nello spazio delle possibili soluzioni andando ad individuare, nel numero minore di passi possibili, la combinazione di tilt elettrici in grado di ottimizzare la funzione obiettivo definita dal sistema stesso. È stata fatta una sperimentazione in campo di tale algoritmo nell’area di Fossano. Lo scenario considerato ha coinvolto circa 130 celle (vedi Fig.A) alcune delle quali con problemi di congestione (celle “over target”). La configurazione dei tilt elettrici trovata da ERIS è stata configurata in rete ed è stato evidenziato un miglioramento in termini di throughput medio per cella dell’ordine di +10% fino a +20% avendo, inoltre, risolto i problemi di celle “over target” presenti prima della riconfigurazione.

roberta.giannantonio@telecomitalia.it

ennio.grasso@telecomitalia.it

giorgio.ghinamo@telecomitalia.it

daniela.mirra@telecomitalia.it

Figura A: Le coperture TIMplan (con elevata risoluzione di calcolo su aree di territorio 10x10 m) nell’area coinvolta dalla sperimentazione e l’approccio utilizzato per l’applicazione del Reinforcement Learning