Nel disegno architetturale è necessario approntare alcuni accorgimenti: uno dei problemi principali è la tokenizzazione dei contenuti, in quanto i motori LLM hanno una limitazione intrinseca del contesto, in termini di numero massimo di token da fornire al modello insieme al prompt di domanda. La conformazione del token varia in base alla tecnologia (ad esempio Open AI utilizza una codifica BPE -Byte-Pair encoding- che corrisponde all’incirca ad una sillaba di una parola) e alla frequenza di occorrenza della coppia di caratteri o byte. Di seguito si elencano alcuni dei metodi utilizzati per passare il contesto (documento tokenizzato e prompt) al modello:

- Stuffing: si passa l’intero documento al modello in una singola chiamata. Poco adatto a documenti di grandi dimensioni (per il rischio di superare la dimensione massima del context), ha il vantaggio di essere più veloce e preciso “al primo colpo” nell’elaborazione della risposta;

- MapReduce: implementa una summarization a più fasi. Più adatto a documenti di grandi; dimensioni, prevede la successione di summarization di chunk del documento e la conseguente combinazione dei diversi summary per ottenere la risposta finale;

- Refine: richiede l’uso di due prompts, la domanda principale che genera l’output per il task successivo e il prompt di refine, che serve a raffinare la prima risposta. Il vantaggio rispetto al mapReduce è ottenere un contesto più rilevante, ma necessita di più chiamate conseguenti, in quanto rispetto al precedente, per sua natura non può parallelizzare i task.

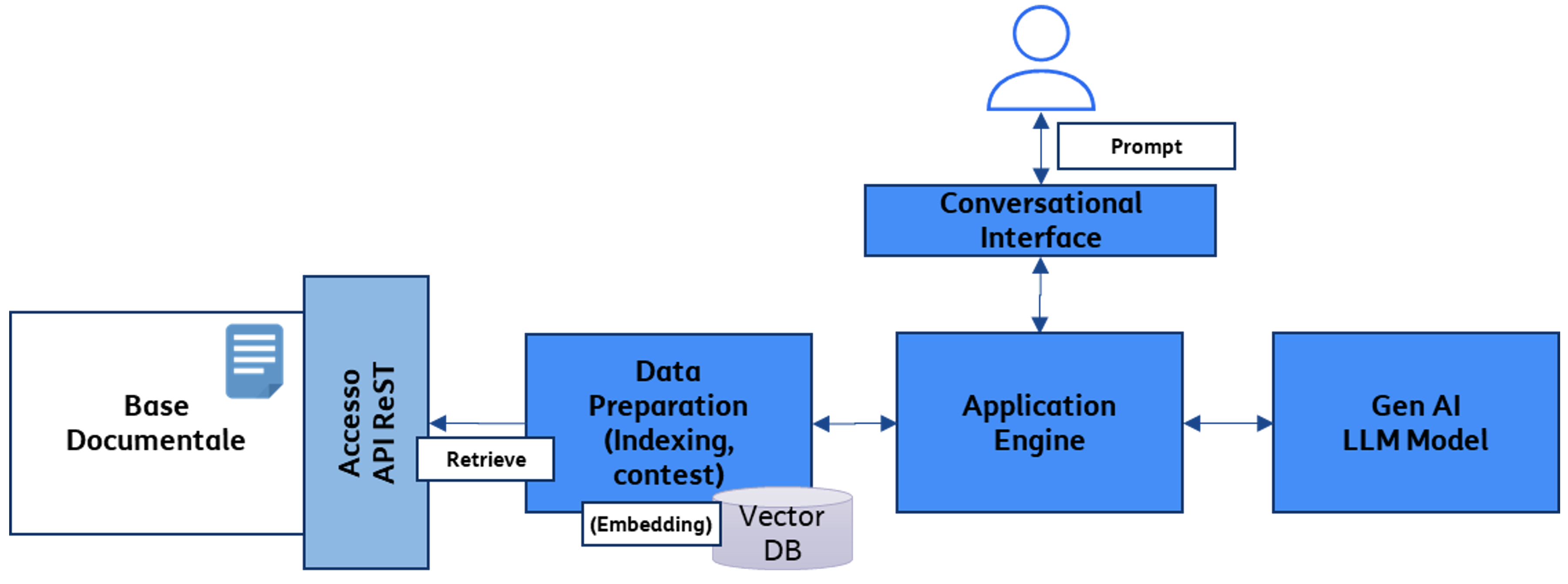

Un altro strumento estremamente potente utilizzabile in questo ambito è l’Embedding, ovvero una rappresentazione vettoriale di un testo. Tale rappresentazione fornisce capacità avanzate di “Semantic Search & similarity”. Utilizzata come input al modello generale LLM permette di creare applicazioni di Search & Summarization documentale specifica su basi dati private come ad esempio repository di contratti, documenti aziendali, manuali di grandi dimensioni, mantenendo il contesto dati circoscritto al perimetro aziendale. Il principio di base è la rappresentazione dei documenti stessi, dei metadati associati ad essi e di altri possibili dati ausiliari tramite uno spazio vettoriale, inteso come vettori numeri in virgola mobile. L’embedding può poi essere indicizzato su un DB vettoriale, per permettere una ricerca a bassa latenza, vincolo critico per alcune tipologie di applicazioni su larga scala [4]. Le scelte tecnologiche per implementare le features richieste dipendono, infine, da vari fattori, tra i quali: costi di licenza per l’uso di uno o più prodotti vendor, opportunità di soluzioni più vicine al “chiavi in mano”, o la possibilità di combinare tra loro capabilities fornite da strumenti open source, in base al grado di maturità e skills del team di sviluppo IT. Un framework di sviluppo open source con un buon grado di completezza è, ad esempio, Langchain. Con esso è possibile sviluppare applicazioni basate su LLM in maniera “vendor-agnostic”, scegliendo la tecnologia più adatta. Langchain fornisce strumenti per la creazione del contesto, per l’interfacciamento con basi di dati documentali, la possibilità di utilizzare i vari modelli forniti dai principali attori di mercato. La caratteristica principale è la possibilità di creare “chain”, cioè catene applicative combinando vari moduli per costruire la soluzione più adatta al proprio requisito.

giovanni.petracca@telecomitalia.it